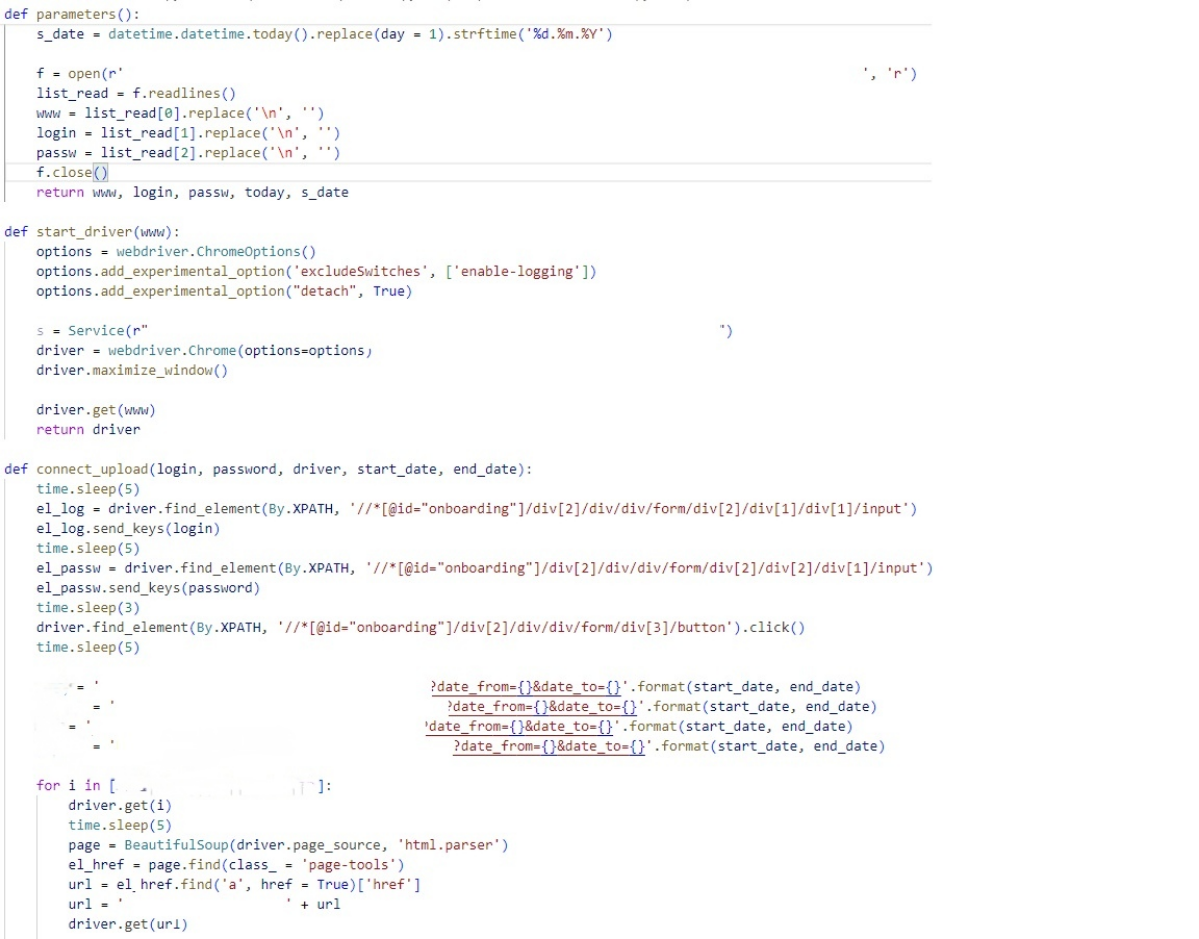

На первом этапе выполнения задачи встал вопрос, что использовать: 1. API запросы. 2. Спарсить готовую таблицу. У каждого метода есть свои плюсы и минусы. В целом, по мне лучше и удобнее API. Но я решил пойти по второму пути, и спарсить готовые данные. В целом из моего опыта парсинга, достаточно не сложный ресурс. Всего то нужно в вести логин и пароль, после авторизации нужно выгрузить 4 таблицы. Выгружаются они за текущий день. Что мне облегчило работу, это то, что даты можно ввести непосредственно в get запросе, т.е. в ссылку их передать. Первый раз с таким удобством столкнулся. Обычно, нужно искать элемент, потом в него вводить дату и т.д. После get запроса нужно было нажать кнопку выгрузить в эксель. И в загрузках будет необходимый файл, и так четыре раза. while True: #история1 #История #python ... ⌨️

· 17.06.2024

Привет! А почему бы вам не скормить спаршенный table td tr сразу в pandas? 🐼 Без всяких танцев с бубном 😄

ответить

коммент удалён

· 17.06.2024

Привет, да согласен это было бы проще. Скорее всего я бы так и сделал, но на тот момент мне показалось проще выгрузить файл. 💾

ответить

ответ удалён

· 17.06.2024

Подпишусь на вас)) мне нравится тема парсинга, сам столько танцевал с бубном 😂

ответить

ответ удалён

· 17.06.2024

Да, это такое мероприятие. 🥁. Но интересное.

ответить

ответ удалён